各位游戏大佬大家好,今天小编为大家分享关于用于gg修改器的root_GG修改器有什么用的内容,轻松修改游戏数据,赶快来一起来看看吧。

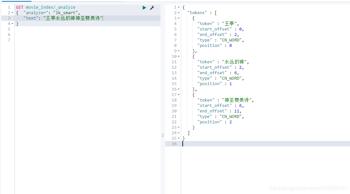

elasticsearch本身自带的中文分词,就是单纯把中文一个字一个字的分开,根本没有词汇的概念。但是实际应用中,用户都是以词汇为条件,进行查询匹配的,如果能够把文章以词汇为单位切分开,那么与用户的查询条件能够更贴切的匹配上,查询速度也更加快速。

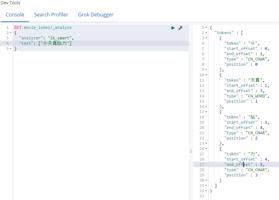

GET _analyze

{

"text": ["wang ting niubi", "今天给力"]

}

#结果如下

{

"tokens" : [

{

"token" : "wang",

"start_offset" : 0,

"end_offset" : 4,

"type" : "<ALPHANUM>",

"position" : 0

},

{

"token" : "ting",

"start_offset" : 5,

"end_offset" : 9,

"type" : "<ALPHANUM>",

"position" : 1

},

{

"token" : "niubi",

"start_offset" : 10,

"end_offset" : 15,

"type" : "<ALPHANUM>",

"position" : 2

},

{

"token" : "今",

"start_offset" : 16,

"end_offset" : 17,

"type" : "<IDEOGRAPHIC>",

"position" : 3

},

{

"token" : "天",

"start_offset" : 17,

"end_offset" : 18,

"type" : "<IDEOGRAPHIC>",

"position" : 4

},

{

"token" : "给",

"start_offset" : 18,

"end_offset" : 19,

"type" : "<IDEOGRAPHIC>",

"position" : 5

},

{

"token" : "力",

"start_offset" : 19,

"end_offset" : 20,

"type" : "<IDEOGRAPHIC>",

"position" : 6

}

]

}

通过示例可以明显看出,“wang ting niubi”,“今天给力”;英文分词根据空格分词相对合理,但中文一个个字拆开显然不合适(今天 、给力 两个词语没有被识别)

分词器下载网址:https:///medcl/elasticsearch-analysis-ik

# 进入es的plugins目录

aaa@ops01:/home >cd /opt/module/elasticsearch-6.6.0/plugins/

# 创建一个插件目录(一个插件对应一个plugins下的子目录)

aaa@ops01:/opt/module/elasticsearch-6.6.0/plugins >mkdir ik

# 下载ik插件zip包

aaa@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik >ls

elasticsearch-analysis-ik-6.6.0.zip

# 解压缩安装包并清理zip文件

aaa@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik >unzip elasticsearch-analysis-ik-6.6.0.zip && rm elasticsearch-analysis-ik-6.6.0.zip

# 目录结构

aaa@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik >ll

total 1432

-rw-r--r-- 1 aaa aaa 263965 May 6 mons-codec-1.9.jar

-rw-r--r-- 1 aaa aaa 61829 May 6 mons-logging-1.2.jar

drwxr-xr-x 2 aaa aaa 4096 Aug 26 2018 config

-rw-r--r-- 1 aaa aaa 54693 Jan 30 2019 elasticsearch-analysis-ik-6.6.0.jar

-rw-r--r-- 1 aaa aaa 736658 May 6 2018 httpclient-4.5.2.jar

-rw-r--r-- 1 aaa aaa 326724 May 6 2018 httpcore-4.4.4.jar

-rw-r--r-- 1 aaa aaa 1805 Jan 30 2019 plugin-descriptor.properties

-rw-r--r-- 1 aaa aaa 125 Jan 30 2019 plugin-security.policy

# 分发插件至其它节点

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik >cd ..

root@ops01:/opt/module/elasticsearch-6.6.0/plugins >scp -r ik ops02:/opt/module/elasticsearch-6.6.0/plugins/

root@ops01:/opt/module/elasticsearch-6.6.0/plugins >scp -r ik ops03:/opt/module/elasticsearch-6.6.0/plugins/

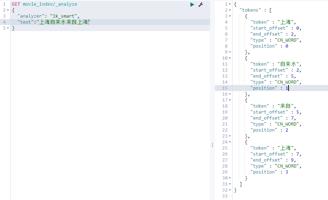

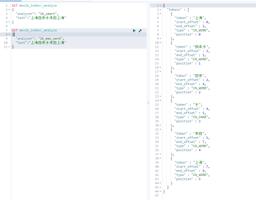

常用的ik分词器功能有ik_smart和ik_max_word

逐个去匹配,每个字使用1次

逐个去匹配,每个字前后能连成词都会展示,相当于尽可能多的形成关系词

【注意】:从上面示例可以看出,不同的分词器,分词有明显的区别,所以以后定义一个type不能再使用默认的mapping,要手工建立mapping来指定分词器, 因为要根据使用场景选择适用合理的分词器

自定义中文词库

生活中,经常会出现一些新的热门词语,比如近期我接触最多的就是yyds永远的神。。。如果始终用之前的词库,那像 永远的神 就可能分成:永远、的、神,不会是我们所想的永远的神作为一个整体。

那这种情况就需要维护一套用户自定义的中文词库。

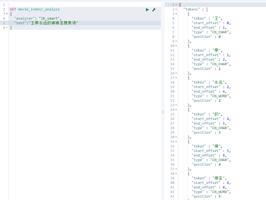

在没有自定义中文词库之前,我们先查一个示例,把结果留下,一会安装完自定义词库后作为对比:

安装前:

安装部署自定义词库:

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config &d

/opt/module/elasticsearch-6.6.0/plugins/ik/config

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >ls

extra_main.dic extra_single_word.dic extra_single_word_full.dic extra_single_word_low_freq.dic extra_ord.dic IKAnalyzer.cfg.xml main.dic preposition.dic quantifier.dic ord.dic suffix.dic surname.dic

# 修改ik插件的config/IKAnalyzer.cfg.xml配置

# <entry key="remote_ext_dict">http://192.168.1.234/fenci/esword.txt</entry> 这行配置一个nginx代理地址

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >vim IKAnalyzer.cfg.xml

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java./dtd/properties.dtd">

<properties>

&ment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 -->

<entry key="ext_dict"></entry>

<!--用户可以在这里配置自己的扩展停止词字典-->

<entry key="ext_ords"></entry>

<!--用户可以在这里配置远程扩展字典 -->

<entry key="remote_ext_dict">http://192.168.1.234/fenci/esword.txt</entry>

<!--用户可以在这里配置远程扩展停止词字典-->

<!-- <entry key="remote_ext_ords">words_location</entry> -->

</properties>

# 切换至有nginx服务的机器上(没有nginx需要自行部署安装)

root@ops04:/usr/local/nginx-1.10/conf #cd /usr/local/nginx-1.10/

root@ops04:/usr/local/nginx-1.10 #mkdir ik

root@ops04:/usr/local/nginx-1.10 #cd ik

root@ops04:/usr/local/nginx-1.10/ik #mkdir fenci

root@ops04:/usr/local/nginx-1.10/ik #cd fenci

root@ops04:/usr/local/nginx-1.10/ik/fenci #echo "王亭" >> esword.txt

root@ops04:/usr/local/nginx-1.10/ik/fenci #echo "永远的神" >> esword.txt

root@ops04:/usr/local/nginx-1.10/ik/fenci #echo "神圣赞美诗" >> esword.txt

root@ops04:/usr/local/nginx-1.10/ik/fenci #cat esword.txt

王亭

永远的神

神圣赞美诗

root@ops04:/usr/local/nginx-1.10/ik/fenci #vim /usr/local/nginx-1.10/conf/nginx.conf

listen 80;

server_name localhost;

location / {

root html;

index index.html index.htm;

}

# 增加如下配置:

location /fenci/ {

root ik;

}

root@ops04:/usr/local/nginx-1.10/ik/fenci #/usr/local/nginx-1.10/sbin/nginx -s reload

# 地址必须和IKAnalyzer.cfg.xml配置项对应;也可以先把nginx弄好再配置IKAnalyzer.cfg.xml合理些

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >curl http://192.168.1.234/fenci/esword.txt

王亭

永远的神

神圣赞美诗

# 修改的xml配置,分发至其它节点

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >scp IKAnalyzer.cfg.xml ops02:/opt/module/elasticsearch-6.6.0/plugins/ik/config/

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >scp IKAnalyzer.cfg.xml ops03:/opt/module/elasticsearch-6.6.0/plugins/ik/config/

# 重启es(各节点)

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >jps | grep Elasticsearch|awk -F" " ’{print $1}’

13077

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >kill -9 13077

root@ops01:/opt/module/elasticsearch-6.6.0/plugins/ik/config >cd /opt/module/elasticsearch-6.6.0/bin/

root@ops01:/opt/module/elasticsearch-6.6.0/bin >./elasticsearch -d

重启es后重新再测试:(已经可以成功识别出新定义的词语)

以上就是关于用于gg修改器的root_GG修改器有什么用的全部内容,游戏大佬们学会了吗?

GG修改器免root游戏,下载高效的GG修改器,无需root即可免费修改游戏 分类:免root版 6,880人在玩 GG修改器是一款功能强大且易于使用的游戏修改工具。不仅如此,GG修改器还能够帮助你在不需要root设备的情况下,轻松地修改Android游戏。如果你喜欢玩游戏并想要探索更多有趣的内容……

下载

gg修改器下载以及免root,GG修改器下载无需Root,轻松实现游戏外挂 分类:免root版 6,969人在玩 GG修改器是一款非常实用的游戏辅助工具,在热门手游中应用广泛。通过使用该软件,玩家可以轻松地修改游戏内的数值、增加游戏道具等,从而取得更好的游戏体验。而且,GG修改器下载还……

下载

gg修改器兔root版,下载gg修改器兔root版,轻松操控游戏 分类:免root版 6,188人在玩 GG修改器兔root版是一款非常实用的游戏辅助工具,它可以为玩家提供各种强大的功能,让你在游戏中轻松地获得胜利。该软件支持多种操作系统,可以在Android和iOS设备上使用。如果您想……

下载

问道手游gg修改器免root,下载问道手游GG修改器,畅享免Root之旅 分类:免root版 5,531人在玩 如果你是一位问道手游的忠实玩家,那么你一定知道GG修改器。这个工具可以让你在游戏中轻松修改金币、钻石等资源,从而让你更容易地闯关升级。而现在,GG修改器已经升级了,支持免Ro……

下载

gg无root修改器怎么用_gg修改器怎么用教学无root 分类:免root版 6,640人在玩 各位游戏大佬大家好,今天小编为大家分享关于gg无root修改器怎么用_gg修改器怎么用教学无root的内容,轻松修改游戏数据,赶快来一起来看看吧。 『 写在前头 』 谷歌 Chrome 浏览器……

下载

怎么给予gg修改器root,软件下载:怎样给予gg修改器root权限 分类:免root版 5,469人在玩 如果你需要使用gg修改器对游戏进行修改,那么你需要在Android手机上获取root权限。虽然这可能会让一些人感到害怕,但是有了正确的工具,这个过程其实非常简单。本文将向你介绍如何……

下载

gg修改器提示要root,下载GG修改器,轻松Root你的设备 分类:免root版 6,826人在玩 在过去,想要修改手机游戏的数据或者卸载预装软件,需要进行root操作。但是,在很多情况下,root操作并不简单,而且可能会对设备造成损害。现在,有一款名为GG修改器的软件出现了,……

下载

gg修改器免root游戏框架,下载gg修改器:轻松实现免root游戏框架 分类:免root版 6,411人在玩 如果您是一名热爱手机游戏的玩家,一定有使用过各种各样的修改器工具来提升游戏体验。但是,一般来说这些修改器需要你的手机已经进行了Root权限申请,对于不懂技术或者没有Root权限……

下载

gg修改器root在哪下载_gg修改器怎么弄root 分类:免root版 8,187人在玩 各位游戏大佬大家好,今天小编为大家分享关于gg修改器root在哪下载_gg修改器怎么弄root的内容,轻松修改游戏数据,赶快来一起来看看吧。 IT之家(www.):升级内核,UC浏览器电脑版……

下载

gg修改器去广告免root_gg修改器修改游戏广告 分类:免root版 6,611人在玩 各位游戏大佬大家好,今天小编为大家分享关于gg修改器去广告免root_gg修改器修改游戏广告的内容,轻松修改游戏数据,赶快来一起来看看吧。 但不管是音乐视频购物还是其他 APP,总是……

下载